Las matemáticas son un misterio grande y hermoso. Aquí hablaremos de como en el siglo pasado se derrumbaron muchas de las bases del pensamiento que las sostenía, especialmente la creencia de que podrían ser completadas, y de que lo único necesario era el esfuerzo humano para poder saberlo todo. Ahora, gracias a Gödel, Turing, y Chaitin, entre otros, conocemos mejor los límites de nuestro entendimiento, y sabemos que lo desconocido es infinitamente más grande. No solamente sabemos que no podremos saberlo todo, también sabemos que hay cosas que nunca sabremos y otras que son a un tiempo verdaderas e indemostrables. Esto no solamente sacudió las bases de las matemáticas mismas, sino que marcó un cambio de dirección en los esfuerzos llevándonos a entender las matemáticas como algo diferente.

Matemáticas y vida

En la carrera evolutiva, no fueron las garras, los músculos, ni los colmillos afilados lo que nos dio ventaja. Ni la vista aguda, el olfato o el oído. Fue el cerebro, nuestro maravilloso cerebro y sus capacidades únicas para el manejo de símbolos y abstracciones, para poder encontrar patrones de repetición, entender los ciclos de la naturaleza, adelantarnos y planear, poner trampas y, sobre todo, para poder comunicarnos y crear culturas que evolucionarían y se transformarían de muchas maneras maravillosas. Fueron estas mismas capacidades de abstracción y de reconocimiento de patrones las que nos acercaron a conceptos numéricos y geométricos que fuimos desarrollando antes de saber siquiera qué estábamos haciendo. Hacíamos matemáticas desde antes de saber que hacíamos matemáticas.

Tenemos que decir que no es que estemos solos en esto, muchos otros animales tienen integradas habilidades matemáticas en sus cerebros, por ejemplo, la habilidad de contar se sabe que no es exclusiva de los primates, ni siquiera de los mamíferos, se ha demostrado que existe en algunas aves, en arácnidos y más recientemente en abejas.

Cuando varias de las especies que tienen la habilidad de contar tienen una distancia genética considerable (como nosotros y las abejas, por ejemplo), decimos que son casos de convergencia evolutiva, es decir, diferentes especies adquirieron dicha habilidad por caminos diferentes, lo que suele pasar cuando se trata de alcanzar alguna habilidad que represente una clara ventaja para la sobrevivencia, como por ejemplo la visión, que es otra habilidad que compartimos humanos e insectos.

Entonces, insectos, arácnidos, aves, mamíferos, y seguramente otros animales poseemos capacidades matemáticas, pero en nuestra especie estas habilidades alcanzaron nuevas alturas.

Nuestras habilidades simbólicas, que nos permiten lo mismo la matemática que la escritura fueron despegando desde el hacer matemáticas sin saberlo buscando y recordando las figuras más estables para acomodar troncos y piedras para hacer nuestros refugios, contar los nudos de las redes, o contemplar maravillados la coincidencia en número de días de los ciclos lunares y menstruales, hasta llegar a conceptos como números, líneas, círculos, y operaciones cada vez más complejas con estos y otros elementes. En cuanto conseguimos separar estas abstracciones geométricas y numéricas del mundo observable las matemáticas pudieron tomar vuelo como abstracción pura sin dejar de ser aprovechadas y reforzadas[i] por la física, que es el estudio de la correspondencia entre las matemáticas y los fenómenos del universo.

Esqueleto del arte matemático

y

y  son congruentes y opuestos por el vértice.

son congruentes y opuestos por el vértice.Tenemos una idea en común, nos parece suficientemente buena y la llamamos axioma. A partir de esos axiomas, y de ciertas reglas, construimos diferentes campos de conocimientos. Por ejemplo, si las ideas que tenemos, los axiomas, son acerca de números, estamos haciendo teoría de números, si estamos hablando de conjuntos, nuestro campo de estudios será la teoría de conjuntos, si hablamos de transformaciones continuas en cuerpos geométricos, decimos que estamos haciendo topología, si hablamos de operaciones, estamos haciendo álgebra. Hay muchas, muchas ramas de las matemáticas, con estrechas relaciones entre ellas. Llevamos haciendo esto desde Babilonia y Egipto, nunca hemos dejado de avanzar en esto, y todavía no sabemos bien qué. Tiene que ver con ideas sujetas a normas que interactúan con otras ideas según las normas que proponemos. O algo así. Y además el universo tiene este mismo lenguaje, o por lo menos uno muy cercano. Hemos conseguido entender las relaciones entre muchos fenómenos de diferentes magnitudes con el motor de matemáticas que lleva en su interior el vehículo de la física. Rrrrn rrrrrrn.

Conforme nos fuimos acercando al desarrollo de todas estas ramas, la pregunta de qué son las matemáticas fue adquiriendo mayor complejidad y nunca ha sido contestada por completo, tal vez nunca lo sea, aunque mucho tiempo las definiciones propuestas tenían que ver con la verdad. El arte que busca la verdad, o que contempla verdades necesarias, ese era el tipo de definiciones propuestas para las matemáticas.

Antes de la primera crisis

Las matemáticas, dijimos, tienen muchos campos de estudio, algunos de los cuales se fueron conectando entre ellos, por ejemplo, la conexión entre el algebra y la geometría se convirtió en la geometría analítica. Pero estos diversos campos seguramente tendrían una base común, ¿no? Una manera de cimentar las matemáticas. Mencionamos antes la teoría de conjuntos donde los conjuntos de elementos pueden estar unidos o intersecando con otros, pueden contener otros conjuntos, ser contenidos a su vez, ser sumados o restados. Esta teoría de conjuntos parecía ser una buena candidata para cimentar la teoría de números que, a su vez, podría sostener buena parte del edificio matemático. Tenemos el conjunto de los números naturales (los enteros positivos), que a su vez es subconjunto de los números enteros (que incluyen al cero y a los números negativos), que a su vez es subconjunto de los racionales (que incluye a los fraccionarios), y así sucesivamente.

Entonces, parecía que todo iba muy bien, las matemáticas eran un edificio con cada vez más plantas, y parecía que tenía buenos cimientos.

Lo ignorado.

En 1872 un fisiólogo alemán, Emil du Bois-Reymond, publicó “Sobre los límites de nuestro entendimiento de la Naturaleza”, un ensayo en el que hablaba precisamente de los problemas que no tenían solución, ni la tendrían, la frase que cerraba este ensayo era la alocución latina ignoramus et ignorabimus que significa lo ignoramos y lo ignoraremos.

En respuesta al pesimismo de Bois-Reymond, David Hilbert, un influyente matemático alemán de la época, en el Congreso Internacional de matemáticas celebrado en Paris en 1900, dijo en matemáticas no existen los ignorabimus. En ese mismo congreso presentó su famosa lista de 23 problemas que influiría en los matemáticos por venir, varios de estos problemas ya se han resuelto, volveremos más tarde sobre esto. Y 30 años más tarde, en una misiva dirigida a la Sociedad de Físicos y Científicos Alemanes, en Königsberg, expandió sus ideas sobre el ignorabimus, diciendo:

No debemos creer a aquellos que hoy, con influencia filosófica y tono deliberativo, profetizan la caída de la cultura y aceptan el ignorabimus. Para nosotros no hay ignorabimus, y en mi opinión en ninguna de las ciencias naturales lo hay. En oposición al necio ignorabimus, nuestro slogan debe ser Wir müssen wissen – wir werden wissen (debemos saber-sabremos).

Hilbert, influyente como era, marcó el tono de muchos matemáticos, además de otros científicos. Aunque hay que decir que el tono no era ajeno a la época sino más bien el zeigeist de entonces. En 1894 el físico Albert Michelson había dicho en la inauguración del laboratorio Ryerson de la Universidad de Chicago que los grandes principios de la física ya habían sido descubiertos y que la física en adelante sería solamente el esfuerzo de alcanzar mayor precisión en la medida. La frase era tan buena que luego se la atribuyeron falsamente a Lord Kelvin.

El Barbero y la crisis.

Bertrand Russel, un filósofo especializado en lógica, encontró una paradoja en la teoría de conjuntos que puede enunciarse así:

Hace muchos años, en un lejano reino, había pocas personas que su oficio fuera ser barbero. Para solucionar el problema, el rey dictaminó que los barberos solo podían afeitar a las personas que no podían afeitarse por sí mismas.

Uno de esos barberos, era el único en su comarca y le entró la siguiente duda: “Como barbero no puedo afeitar al barbero de mi comarca, que soy yo, porque entonces podría afeitarme a mí mismo. Pero entonces, algún barbero debe de afeitarme, pero como soy el único que hay, entonces no me puedo afeitar”.

Aquí el razonamiento empieza a dar vueltas sobre sí mismo, pues si nuestro amigo barbero no se puede afeitar a sí mismo, entonces debe poder afeitarse. Esto es, tenemos problemas de consistencia cuando hablamos del conjunto de todos los conjuntos si este conjunto se contiene a sí mismo.

Al poner en evidencia esta paradoja de la teoría de conjuntos, que era una rama de las matemáticas que tenía la virtud de poder servir de base para otras ramas de las matemáticas (por ejemplo, la teoría de números podía ser deducida de la teoría de conjuntos), comenzó la llamada crisis fundacional de las matemáticas (Grundlagenkrise der Mathematik en alemán).

Esta pudo subsanarse mediante un parche sencillo pero molesto: no existen conjuntos que se puedan contener a sí mismos. Esta no era una solución elegante, y se levantaron muchas cejas. Ya no parecía seguro confiar completamente en la teoría de conjuntos como una base firme.

El programa de Hilbert

Entre las soluciones a la pregunta ¿qué son las matemáticas? está el formalismo. En el formalismo las matemáticas solamente tienen interés en las relaciones marcadas por las reglas y los axiomas y sus valores de verdad o falsedad, sin importar sus posibles referentes del mundo real. Entonces, las matemáticas serían el estudio de dichas reglas y axiomas en busca de la verdad. El mundo no les importa ni les interesa, de manera que no son matemáticas que sirvan para contar objetos del mundo real (esta fue una objeción de Russel al formalismo[ii]), solamente son sistemas axiomáticos que existen en algún espacio abstracto para relacionarse entre ellos. Un ballet de signos, coreografía barroca.

Estamos hablando de finales del XIXy principios del XX, siendo David Hilbert el principal exponente de esta corriente. Hilbert es uno de esos gigantes que construyó el futuro pues sus matemáticas sirvieron para fundamentar parte de la física cuántica y la relatividad general que a su vez impulsa nuestra tecnología.

Hilbert propuso un plan de trabajo, el programa de Hilbert. En él se les pedía a los matemáticos que desarrollaran un nuevo lenguaje formal que tuviera reglas claras, que fuera completo (que todo lo que se puede probar en matemáticas se pueda probar en este lenguaje), que fuera consistente (no se puede probar la verdad y la falsedad de algo en ese sistema, no puede haber contradicciones) y decidible (debe existir una manera de determinar ya sea la verdad o la falsedad de una afirmación).

Este programa resolvería el segundo de la lista de los Problemas de Hilbert, probar que los axiomas de la aritmética son consistentes, y sería algo así como el cimiento del formalismo.

El esfuerzo de Russel y Whitehead

Bertrand Russel y Alfred North Whitehead publicaron entre 1910 y 1913 los tres volúmenes de su Principia Mathematica, en dónde pretendían establecer bases axiomáticas claras cumpliendo así el programa de Hilbert. Este trabajo de lógica simbólica impresionante fue concebido como la respuesta al programa de Hilbert y por unos años parecía que se había cumplido el sueño de tener bases sólidas, el juego de axiomas y reglas consistente y completo que Hilbert había pedido. No importaba que cualquier demostración fuera excesivamente verbosa y engorrosa si se hacía mediante esta notación, a fin de cuentas, una vez realizada la demostración esta quedaría para siempre inscrita con piedra en el libro divino de las demostraciones matemáticas libres de inconsistencia, era todo cuestión de trabajo duro y laborioso, pero los cimientos parecían sólidos.

Un viejo sueño, el Entscheidungsproblem.

Ya Leibniz había soñado con una máquina de generar teoremas, lo que Hilbert pedía en su programa era el lenguaje en el que dichos teoremas serían escritos por la máquina. Una vez establecido dicho lenguaje sería posible efectuar un trabajo de fuerza bruta de combinatoria con los símbolos del lenguaje para obtener todos los teoremas, el final de la matemática. O al menos este era el otro sueño de Hilbert, el Problema de Decisión, Entscheidungsproblem en alemán, que presentó en 1928 junto con Wilhelm Ackermann, el problema de encontrar un algoritmo capaz de determinar si un teorema era o no válido según las reglas axiomáticas de un sistema dado. Si esto fuera posible, significa que existiría El Libro, el conjunto de las combinaciones posibles de símbolos que forman teoremas válidos, el total de los teoremas válidos estaría ahí, al alcance de un esfuerzo enorme, monstruoso, pero finito. Todo lo que necesitaríamos es un ingente trabajo de combinatoria que nos permitiera alimentar a nuestro algoritmo que entonces iría descartando o aceptando como válido cada combinación de axiomas y reglas hasta descubrir el edificio completo, magnífico en su enormidad y belleza.

Los teoremas de Gödel. Un sueño se rompe.

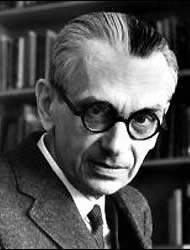

En 1931 Kurt Gödel comenzó la demolición. Demostró que los sistemas matemáticos siempre tendrán la incompletitud y la indecidibilidad aseguradas por los mismos axiomas que lo componen.

Lo que hizo Gödel fue demostrar primero que todo axioma del Principia Mathematica (lo abreviaremos PM) podía convertirse en números, que entonces trataría según las reglas básicas de aritmética (aritmética de Peano). A partir de ahí inicia una ruta para encontrar un enunciado que es verdadero pero indecible. Y lo logra. Logra producir una sentencia que afirma de sí misma su indecibilidad. Me detengo un instante para contemplar la belleza del esfuerzo de Gödel que hace todo un tour de force para crear una sentencia que dice: la verdad de esta sentencia no puede ser probada.

No era solamente que el sistema que Russel proponía era incompleto, la teoría de números era incompleta, no hay manera de tener un sistema axiomático que sea completo, al menos mientras sea un sistema axiomático tal que soporte a la teoría de números y cierta aritmética básica pueda llevarse a cabo. Dentro de cada uno de estos sistemas, llámese teoría de conjuntos, notación Russel-Whitehead, o aritmética de Peano, habrá enunciados que sean indecibles, esto es, que son verdaderos pero que no pueden ser probados según las reglas del sistema, la única manera de probarlos es agregarlos como axiomas del sistema.

El primer teorema de incompletitud de Gödel puede enunciarse como:

Cualquier formal consistente F dentro del cual ciertas operaciones de aritmética elemental puedan ser llevadas a cabo es incompleto; esto es, hay enunciados del lenguaje F de los cuales no puede ser probada su verdad ni su falsedad en F.

En cada sistema que se pueda concebir, en el que podamos escribir que 1+1=2, o del cual podemos derivar este hecho, tiene un hueco, una sentencia de Gödel, que no puede ser probada, aunque sea verdadera.

O más sencillamente:

Cualquier teoría aritmética recursiva no es consistente.

El segundo teorema de la incompletitud puede enunciarse así:

Para probar la sentencia de Gödel de un sistema F, esta sentencia puede agregarse como corolario, formando el sistema F’, que contiene a F.

Esto es, no existe un sistema último, pues todo sistema formal tiene sentencias que no pueden ser probadas dentro de un sistema, sino desde otro sistema más grande que a su vez tendrá sentencias que solamente puedan probarse en otro sistema más grande y así sucesivamente.

Por favor, repitan conmigo: hay enunciados verdaderos e indecidibles.

Esto fue un verdadero golpe, si bien uno de la que las matemáticas consiguieron recuperarse, las lógicas de primer orden (como las de los PM) seguían siendo válidas para probar casi todo excepto las sentencias de Gödel, pero ahora sabemos que hay un hueco que nunca podrá ser rellenado en todas estas lógicas y este es un hecho que provocó una desazón generacional por un tiempo en los matemáticos.

El problema de la decisión y el problema de la parada.

Alan Turing en 1937 público su artículo Acerca de los números computables, con aplicación al problema de la decisión. Este artículo tuvo y tiene una importancia a muchos niveles. Por una parte, da al traste con el sueño de encontrar una máquina de verificar teoremas, lo hace usando una estrategia que ya había sido usada con mucho provecho por Cantor para hablar acerca de los infinitos, usando una demostración por diagonalización, y para ello construye unas máquinas mentales que resultarían ser una herramienta poderosa con alcances profundos en nuestra concepción del mundo, hablo de las computadoras.

Ya en otro artículo hablé de las máquinas de Turing, de su definición y propiedades, de manera que, aunque aquí lo repasaré brevemente, ruego al lector interesado que lea primero ese artículo.

Turing describe un dispositivo ideal, él la llama máquina automática o máquina a, pero nosotros la llamamos máquina de Turing y la abreviaremos MT, esta máquina es capaz de seguir tablas de instrucciones escritas en un lenguaje simbólico y de acuerdo con dichas instrucciones manipula símbolos en una cinta hasta llegar a su estado final, el estado de detención. Cada MT es equivalente a seguir las instrucciones de la tabla, es decir a efectuar un solo programa. Aquí es donde comienza la magia.

Dado que las instrucciones vienen codificadas, este código puede convertirse a números, cada MT puede convertirse en un número. Turing imagina una Máquina Universal, ahora conocida como Máquina de Turing Universal o MTU; esta máquina es capaz de leer de su cinta el código de una MT y ejecutarlo. Aquí Turing está describiendo las funciones básicas de nuestras computadoras en la década de los 30´s del siglo pasado usando construcciones mentales. No solamente le da un significado preciso a la palabra algoritmo como aquello que puede ser codificado en una MT, sino que demuestra que esas máquinas pueden existir virtualmente dentro de otras.

Hay una equivalencia entre una MT y un programa, de hecho, Alonzo Church había llegado al mismo resultado unos meses antes mediante el Cálculo Lambda, al que ahora podemos entender como un lenguaje de programación de bajo nivel, un lenguaje en el que se podían escribir programas. Turing había ideado la máquina de seguir instrucciones de un lenguaje formal, y Church había descrito uno de esos lenguajes formales y los dos, el cálculo lambda de Church y las máquinas de Turing eran equivalentes, es decir, cualquier función computable puede ser expresada y evaluada en uno u otro sistema.

Usando estas herramientas mentales, Turing construye varias pruebas para mostrar que hay funciones no computables, o lo que es lo mismo, indecidibles computacionalmente. Turing y Church daban origen así a las ciencias de cómputo, al tiempo que quebraban otro sueño de Hilbert, no podríamos nunca encontrar un algoritmo que pueda determinar si un teorema es verdadero, la computación nace conociendo sus límites, los problemas incomputables.

¿Dónde estamos hasta ahora?

Ya vimos que las matemáticas sufrieron un golpe con el teorema de incompletitud de Gödel, que demostró que los sistemas formales no pueden ser completos, y que habrá problemas indecidibles en cada sistema, después, Turing nos mostró que no existe un algoritmo perfecto para verificar un teorema, no podemos automatizar la búsqueda de teoremas, echar la máquina a andar y ponernos a tomar café por algunos siglos en lo que la máquina encuentra todos los problemas y termina por completar a las matemáticas, no funciona así.

Afortunadamente, esto no representó el fin de las matemáticas ni mucho menos, las lógicas formales son confiables hasta cierto punto, no podemos tener todo, pero tenemos mucho. Y la automatización de la verificación de problemas ha avanzado bastante, no podemos probar ni generar todos los teoremas, pero podemos avanzar bastante. Fue la parte totalitaria del sueño la que se vino abajo, no podemos tener sistemas formales absolutamente completos ni podemos librarnos absolutamente de los problemas indecibles.

Tal vez, entonces, lo que nos queda es elaborar algoritmos cuidadosamente, de forma que nadie pueda quitarnos el placer de encontrar el mejor algoritmo para cada tarea, mucho trabajo por delante, pero una vez que estemos seguros de que encontramos el camino más corto, habremos plantado otra piedra en el edificio. Seguramente no pueden quitarnos eso, ¿o sí?

La teoría algorítmica de la información

Gregory Chaitin desarrolló en la década de los sesenta del siglo pasado, junto con Andrei Kolmogorov, y Ray Solomonoff, la teoría algorítmica de la información, donde establecen la idea de complejidad algorítmica grosso modo puede explicarse así: tenemos una cadena, ya sea una cadena de caracteres, o una cadena numérica. Esta cadena tendrá más complejidad entre más grande sea el programa necesario para generarla, es decir, una cadena del tipo 01010101010101 repetida mil veces solamente necesita una expresión tipo:

Mientras el largo de la cadena sea menor a mil:

{escribir uno,

escribir cero

}

Mientras que el programa para genera una cadena aleatoria necesitará llevar la cadena entera en el programa, las cadenas aleatorias no pueden ser comprimidas. Guarden esta propiedad en mente, volveremos a ella.

También estableció la definición de programa elegante como aquel programa que llega a un resultado con el menor número de instrucciones ¡Y demostró que no puede demostrarse que un programa es elegante!

Esto representó algo como un tiro de gracia a nuestros sueños, pues significa que nunca podremos estar seguros de estar haciendo algo de la menor manera posible, siempre existe la posibilidad de que exista un camino más corto para realizar una tarea. Podemos tener algoritmos eficientes, pero nunca podremos estar formalmente seguros de haber encontrado el algoritmo más eficiente. Esto es una pesadillo o una bendición según se mire. Antes dijimos que las cadenas aleatorias son, en la teoría de la complejidad algorítmica, aquellas que no pueden ser comprimidas. Aquellas cuyo programa no puede ser menor que la propia cadena. Ahora, al decir que no podemos saber si un programa es realmente el más corto posible, estamos diciendo también que no podemos estar seguros de la aleatoriedad de la cadena. La aleatoriedad es una medida de nuestro desconocimiento: si supiéramos cuál es el siguiente digito de una serie esta dejaría de ser aleatoria; ahora estamos viendo que tenemos desconocimiento acerca de la aleatoriedad misma. No podemos estar seguros de que lo que pasa es que no conocemos el algoritmo para conseguir esa cadena aleatoria. Si no podemos estar seguros ni de la aleatoriedad misma, todo es ignorancia.

A Chaitin le gusta demostrar la magnitud de nuestra ignorancia, y nos ha dado algunos ejemplos más de esta infinita ignorancia. Uno de ellos es la constante de Chaitin, también llamado el número Ómega (Ω), podemos definirlo así: cada dígito después del cero es un bit (un cero o un uno) que indica si una máquina de Turing formada aleatoriamente se detiene o no (1 si se detiene, 0 si no se detiene).

Este número se puede describir, pero no se puede computar, además de que tiene propiedades muy curiosas, es el primer número que es un número normal[iii] en cualquier base conocida. Uno de los casos de normalidad demostrada es el número de Champernowne, en el que se ha demostrado su normalidad en base 10, pero no se ha probado que este mismo número sea normal en otras bases, al contrario de la constante de Chaitin que, aunque incomputable, es normal en cualquier base. Además de normal e incomputable, tiene la propiedad de ser incomprimible, es decir, para obtener un dígito de ese número es necesario correr una máquina de Turing, y por definición no se puede saber de antemano si se detuvo o no. Esto es, no hay una manera corta de llegar a ese número porque no se puede saber cuál será el siguiente dígito. Es, por tanto, un número perfectamente aleatorio, en el sentido de que al calcularlo no se puede conocer el siguiente dígito de su serie.

Otro enorme misterio, los números trascendentes.

Acabamos de definir un número trascendente, Ω, y existen otros, de los cuales es más conocido es π aunque también esta e y un puñado más de números conocidos. Son números que no se pueden escribir como el resultado de una ecuación algebraica, también se llaman números no algebraicos, y existen métodos para aproximarlos. A estos números hemos llegado un poco por ventura, son extremadamente raros de encontrar en el mundo de las matemáticas. Si te encuentras con un matemático en una fiesta y no para de hablar, siempre puedes preguntarle por cinco números trascendentes entre cero y uno. Tal vez incluso se vaya de la fiesta, así que no abusen de este poder.

La cuestión es que Cantor, el matemático que amaba los infinitos, también amaba comparar infinitos, y demostró que el infinito de los números trascendentes es mayor que el de los números algebraicos. Lo hizo de una manera muy opaca, llegó a una contradicción al suponer que era un infinito numerable, como el de los números naturales, y por tanto se deduce que es un infinito no numerable. Si metes la mano cada segundo en un cubo que contenga todos los números conocidos para sacar un número al azar, te vas a encontrar un número trascendente cada vez que lo saques y alguna vez entre eternidades inimaginables de tiempo te saldría un número algebraico.

El mismo Russel ya conocía esta paradoja, este hueco terrible en el corazón de las matemáticas, había escrito en 1959:

Los decimales que no terminan a veces proceden de acuerdo con una ley que nos permite calcular cuántos términos como queramos. Pero a veces (debemos suponer) no proceden de acuerdo con ley alguna. Como principio generalmente aceptado este último caso es infinitamente más común que el primero, y, a menos que estos decimales “sin ley” sean admitidos, la totalidad de la teoría de los números reales colapsa y, con ella, el cálculo infinitesimal y casi todas las matemáticas superiores.

Hay una cuestión aquí que pone en dimensión la magnitud de nuestra ignorancia de una manera bonita y apropiada. Entre cero y uno solamente conocemos un puñado de números trascendentales, un puñado de un infinito. Así de pequeño es nuestro conocimiento. Así de grandes las lagunas que tenemos.

Isomorfismo Curry-Howard

Aquellos lectores que estudiaron geometría analítica recordarán que existe una correspondencia entre las ecuaciones algebraicas y sus representaciones como curvas en un plano. Algunos problemas eran más tratables algebraicamente mientras que otros lo eran geométricamente. Este es un caso de isomorfismo, una relación de correspondencia entre dos conjuntos que nos permite tratar un problema de una forma o de otra indistintamente según sea conveniente. Las matemáticas están llenas de ejemplos así, las diferentes ramas de las matemáticas trazan correspondencias entre sí. El isomorfismo Curry-Howard, llamado así por el Matemático Haskell Curry y el lógico William Alvin Howard, establece que existe un isomorfismo entre los programas y las demostraciones, y esto tiene consecuencias muy interesantes, por ejemplo, ya sabemos que no se puede demostrar que un programa sea elegante, es decir que sea este escrito de la manera más compacta posible. Entonces este isomorfismo implica que nunca podremos saber que una demostración dada sea la manera más corta de llegar a demostrar un teorema, siempre puede que exista otra que lo logre de una manera más corta.

Hace poco una IA fue entrenada para resolver el problema de los tres cuerpos muchísimo más rápido que por los métodos tradicionales[iv].

Los métodos que conocemos, que se desprenden de la ley de atracción entre masas de Newton, necesitan un poder de cómputo enorme y un tiempo considerable para simular dicho problema, mientras que el método de la máquina lo logra mucho más rápido, pero este tipo de IA, las redes neuronales, son opacas completamente en su funcionamiento, es como si ni ella misma supiera cómo lo hizo. Un poco como cuando nos piden que levantemos un brazo, la manera en que lo hacemos a nivel señales neuronales es opaca para nosotros, aunque seamos los que movemos el brazo. La cuestión es que lo que sea que haga lo está haciendo más elegantemente que nosotros.

¿A dónde vamos con todo esto?

Resumiendo, las matemáticas han sido siempre un campo fascinante y tan enorme que es muy difícil de definir. Por mucho tiempo se pretendía que se trataba de la búsqueda de la verdad, y luego resultó que esa verdad está por decirlo de alguna manera, acotada, no se puede conseguir por completo. Se demostró que nunca podremos ser completos ni consistentes, que hay enunciados indecibles y funciones incomputables, y que ni siquiera podemos llegar a saber que las demostraciones de los teoremas encontradas son las mejores soluciones.

No podemos estar seguros ni siquiera de la aleatoriedad misma. Todo es ignorancia. Pero también todo es posibilidad. En el camino encontramos herramientas mentales como las computadoras que revolucionaron nuestra manera de entender el mundo ¡y también de entender las matemáticas!

Ahora que nos despojamos de muchas de nuestras pretensiones al comprender que son imposibles, nos volvemos a preguntar ¿qué son las matemáticas?

Dice Chaitin que tal vez podemos entenderlas como un arte experimental, algo más cercano a la física, ahora que podemos probar introduciendo nuevos axiomas, en vez de creer que estos son fijos e inmutables, y ver el resultado de ello, un poco como cuando la geometría decidió permitir paralelas que se cruzan o se encuentran, dando lugar a nuevas geometrías, y otro poco como cuando Konrad Lorenz graficó por medio de computadoras sus atractores extraños y Mandelbrot sus fractales.

Quiero detenerme un poco en esta parte del paisaje. No solamente tenemos verdades indemostrables, sabemos que no aspiramos nunca a ninguna completitud, inventamos el cómputo para demostrar lo incomputable, usamos el cómputo para definir la aleatoriedad, pero no sabremos nunca si lo que tenemos enfrente es aleatorio realmente. Esta es de esas situaciones en donde vale la pena recurrir a la imagen de la barquita en el océano, haciendo notar que en este caso el océano es infinito.

Ahora enfrentados a este paisaje, podemos pensar en diferentes métodos de pesca en la búsqueda de verdades, dejamos de pretender que nuestros axiomas son otra cosa que afortunadas inspiraciones, y probamos usando axiomas nuevos, encontrando castillos a cada paso, como cuando modificando uno de las axiomas de la geometría en espacio plano, que era la única conocida, descubrimos o inventamos geometrías de los espacios curvos, podemos seguir lanzando axiomas de manera más libre, y ver qué pasa con aquellos que parezcan productivos. No es que no estemos haciendo cosas parecidas, es que podemos sentirnos más libres para ello, regresando al antiguo dilema que no sabía si colocar a las matemáticas como un arte o como una ciencia, podemos complejizar un poco entendiendo que arte y ciencia son categorías del pensamiento que usamos para poner un poco de orden aquí, pero no es que tengan que tener una división rígida, hay siempre bastante de arte en la ciencia y de ciencia en el arte, pero no sé si en alguna otra área aparte de las matemáticas existe tanto de ambas.

Una de las principales objeciones para darle a las matemáticas el título de ciencia era que esta no cumple con el método científico, pues no tiene hipótesis que someter a demostración experimental. Desde que las computadoras forman parte del arsenal de los matemáticos, esto ya no es tan verdad. Las computadoras son una herramienta formidable para adentrarnos como exploradores en reinos extraordinarios como los de la geometría fractal, en que las iteraciones de unas cuantas ecuaciones interactuando entre ellas de manera no lineal forman paisajes geométricos increíblemente hermosos. Bueno, esto y muchos otros caminos de la matemática computacional se dedican a experimentar, justamente lo que no se creía que las matemáticas podrían hacer.

Hay casos en que es difícil separar la historia de los conceptos de la historia de su etimología, así pasó con el concepto de arte, que tomamos de la palabra latina ars, artis que en los primeros registros se usaba para indicar cualidad, y después, habilidad, para luego terminar como un calco semántico del techne griego, algo así como el conjunto de conocimientos relacionado a una actividad, que es de hecho una acepción que se sigue usando hoy en día, decimos el arte de la jardinería, y es el mismo significado de techne.

Fue a partir del renacimiento que se comenzó a hablar de arte como creación estética, en contraposición a arte como técnica o habilidad.

Las matemáticas reciben esta amalgama semántica de buena manera, son arte en el sentido de técnica, y habilidad, pero también lo son en el sentido creativo. Para aprender matemáticas se usa una parte lógica de nuestro pensamiento, pero para crear matemáticas hace falta una cierta cualidad de la imaginación, en conexión con la intuición y el valor de quien se adentra en lo desconocido. Ahora que sabemos que lo que desconocemos es infinito, podemos liberarnos del peso de conocer la verdad, relajarnos y disfrutar el paseo, permitiéndonos ser más atrevidos, más libres, al tiempo que tenemos nuevos instrumentos para ayudarnos a probar nuestras hipótesis en esto que es descubrimiento e invención del infinito.

[i] Si tengo que mencionar a la física al hablar de las matemáticas es porque la física por definición es matemáticas aplicadas, pero el universo es un misterio enorme y profundo de manera que em el esfuerzo de agotar la comprensión sobre los fenómenos de este universo fuimos necesitando nuevas matemáticas, de manera que entre los físicos y matemáticos existe un fecundo intercambio, progresos en matemática pueden resultar teniendo aplicaciones físicas y los progresos en física muchas veces implican la creación de nuevas matemáticas.

[ii]Russell, B. My philosophical development.

[iii] La normalidad de un número según fue definida por Emile Borel (normalidad de Borel) se cumple cuando las apariciones de sus distintos dígitos se encuentren perfectamente distribuidas en la cadena, es decir, pensando en la normalidad en base 10, y examinando la ocurrencia de un dígito cualquiera, el 1 o el 5 o el que sea, esta ocurrencia será exactamente del 10% de las veces; si pensamos en base 2, los ceros y los unos aparecerán 50% de las veces cada uno. La normalidad ocurre en los números trascendentes, que son aquellos que no se pueden representar como el resultado de una ecuación algebraica, como π, aunque en el caso de π la normalidad no ha sido demostrada, sabemos que la frecuencia de los dígitos de π tienden a la normalidad a medida que conocemos más dígitos del número. Es decir, sabemos que la normalidad ocurre en los números trascendentes, aunque esta no pueda ser demostrada más que en unos cuantos casos.

[iv] En la IA, se le conoce como redes neuronales artificiales a un modelo inspirado por las neurociencias en que se tienen varias capas de nodos, llamados neuronas, que son atravesados por conexiones. Estas conexiones tienen un valor, llamado peso. En el entrenamiento de estas redes se les alimenta con ejemplos y se califican sus intentos de reconocer o generar sus objetivos de manera que cuando realizan la tarea de manera correcta tienen mejores calificaciones, lo que aumenta el peso de las conexiones que las llevaron a ese resultado. Estas conexiones son de una complejidad tal que es imposible saber como fue realizada la acción para la que se le entrenó cuando esta se cumple exitosamente. Es decir, las redes neuronales no son explicativas.